Wie KI den Blick in die Zukunft ermöglicht

Ein Blick in die Zukunft, um zu sehen, was das Morgen bringt. Dieser Traum ist so alt wie die Menschheit. Und was früher Priestern, Schamanen und Orakeln oblag, das soll heute die KI leisten. Sind die Ergebnisse ebenso verlässlich, wie die Rituale unserer Vorfahren? Oder bietet uns künstliche Intelligenz tatsächlich einen Weg, den Schleier der Zeit zumindest ein Stück weit zu lüften?

Prädiktive Analyse (engl. unter anderem Predictive Analytics) bezeichnet die Nutzung von Daten, Statistik und Machine Learning, um zukünftige Ereignisse oder Verhaltensweisen vorherzusagen. Sie spielt eine zunehmend wichtigere Rolle in Unternehmen verschiedenster Branchen vom Finanzwesen über das Marketing bis zur Medizin und Logistik.

Grundlagen der Predictive Analyse

Aussagen über zukünftige Ereignisse treffen zu können, klingt wie Magie. Nüchtern betrachtet ist diese Form der Zukunftsvorhersage aber weit weniger geheimnisvoll, als es einschlägige Magazine und Websites verkaufen möchten. Es handelt sich um einen Teilbereich der fortgeschrittenen Analytik, selbst wiederum Teilbereich der Informatik. In diesem liegt der Fokus auf der Mustererkennung in großen Datenmengen. Diese werden mit statistischen Modellen und Technologien aus dem maschinellen Lernen verknüpft. So lassen sich mithilfe stochastischer Modelle Vorhersagen treffen.

Mit Magie hat das Ganze allerdings nichts zu tun. Es handelt sich um die Berechnung von Wahrscheinlichkeiten. Dahinter steckt also schlichte Mathematik. Dank Cloudspeicher und zunehmend Digitalisierung stehen mittlerweile riesige Mengen an Daten in digitaler Form und jederzeit abrufbar zur Verfügung. Glasfaser und immer leistungsfähigere Prozessoren ermöglichen eine schnelle Verarbeitung. Und KI-Systeme schließlich sind hervorragend darin, sich durch diese Datenmengen zu arbeiten und sie nutzbar zu machen.

Wir brauchen mehr Daten

Grundlage der Prädiktiven Analyse sind Daten. Egal ob Unternehmen, wissenschaftlichen Einrichtungen oder Verwaltungen – überall sammeln sich im Laufe der Zeit riesige Mengen an Daten an: E-Mails, Rechnungen, Konzepte, Präsentationen, Ausarbeitungen, Analysen, Bilder, Grafiken, Verträge, Bedienungsanleitungen, Videos, Audio-Dateien. Diese Informationen werden meist gespeichert, weil sie vielleicht noch einmal jemand benötigt – und dann in den allermeisten Fällen vergessen.

Sich diese Datenmengen nutzbar zu machen, kann für zahlreiche Unternehmen lohnend sein, um die eigenen Arbeitsprozesse zu optimieren. In der Medizin lassen sich dann in Minuten tausende Falldaten auswerten, was völlig neue Behandlungsmethoden ermöglicht. Wissen von Mitarbeitern geht nicht mehr verloren und lässt sich sogar weiternutzen, wenn diese in Rente gehen oder den Arbeitgeber wechseln. Und der Lieferverkehr – und mit ihm auch alle anderen Teilnehmer am Straßenverkehr – profitiert von einer immer effizienteren Routenplanung.

Mustererkennung: Mensch vs. Maschine

Für einen Menschen ist die Aufgabe kaum schaffbar, alle diese Informationen durchzugehen, zu ordnen und dann Muster in diesen zu entdecken. Sie sinnvoll zu klassifizieren und dann auch noch so aufzubereiten, dass andere diese nutzen können, ist eine umfangreiche, in vielen Fällen kaum zu bewältigende Aufgabe. Für die KI ist das kein Problem, sondern vielmehr täglich Brot.

Ist das System schließlich soweit trainiert, dass es Muster erkennen kann, werden aktuelle Daten eingegeben. Aus diesen lassen sich dann anhand der benannten Muster Wahrscheinlichkeiten errechnen, mit denen bestimmte Ereignisse in der Zukunft eintreten.

Neben klassischen Unternehmensdaten wie Verkaufszahlen oder Produktinformationen werden zunehmend Daten aus Social Media, dem Internet der Dinge (IoT), Sensoren, Wetterdaten, Börsenkursen und sogar Interaktionen auf Webseiten analysiert, um komplexe Muster und Trends zu erkennen. Dadurch können Unternehmen nicht nur vergangene Entwicklungen nachvollziehen, sondern auch individuelle Kundenbedürfnisse, Marktreaktionen oder Maschinenzustände nahezu in Echtzeit prognostizieren.

Methoden und Modelle

Es gibt eine ganze Reihe von Begriffen, die in Zusammenhang mit Predictive Analytics auftauchen, die aber den wenigsten Menschen geläufig sind. Es handelt sich hierbei meist um erprobte Methoden und Modelle aus Mathematik und Informatik, mit deren Hilfe sich beispielsweise Daten erheben, erschließen oder verarbeiten lassen. Diese Modelle sind das, was wir gemeinhin unter dem Begriff KI zusammenfassen.

Ein kurzer Überblick:

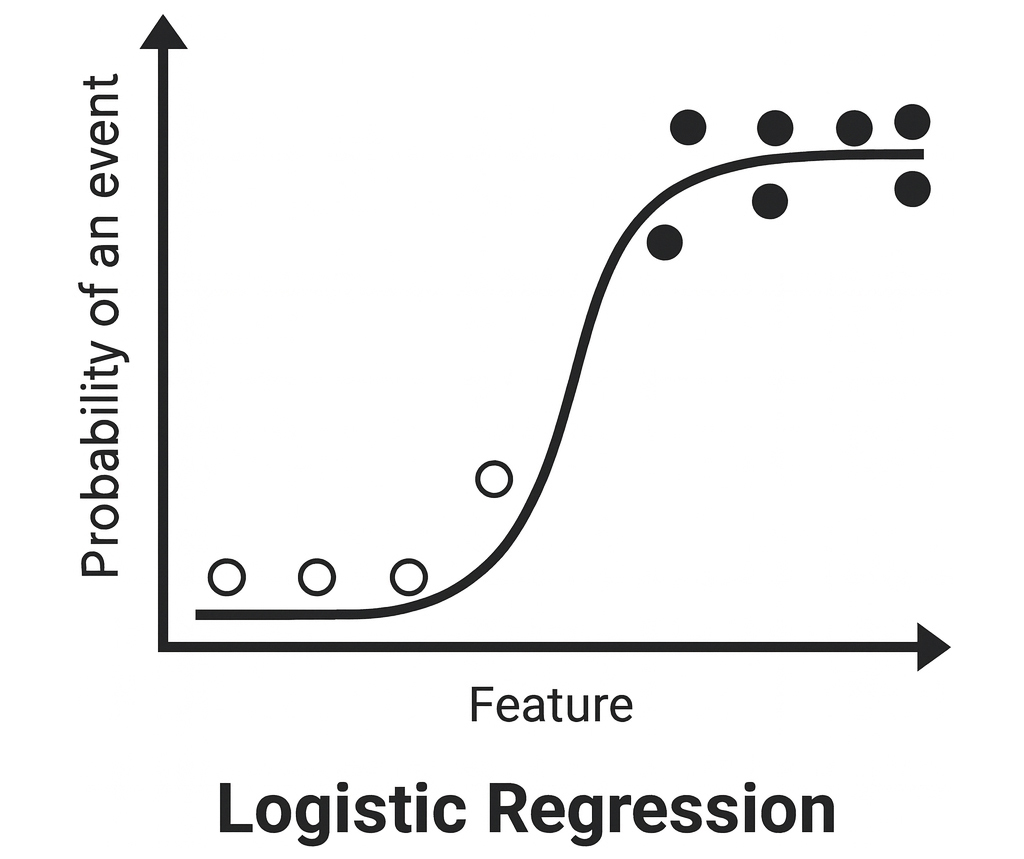

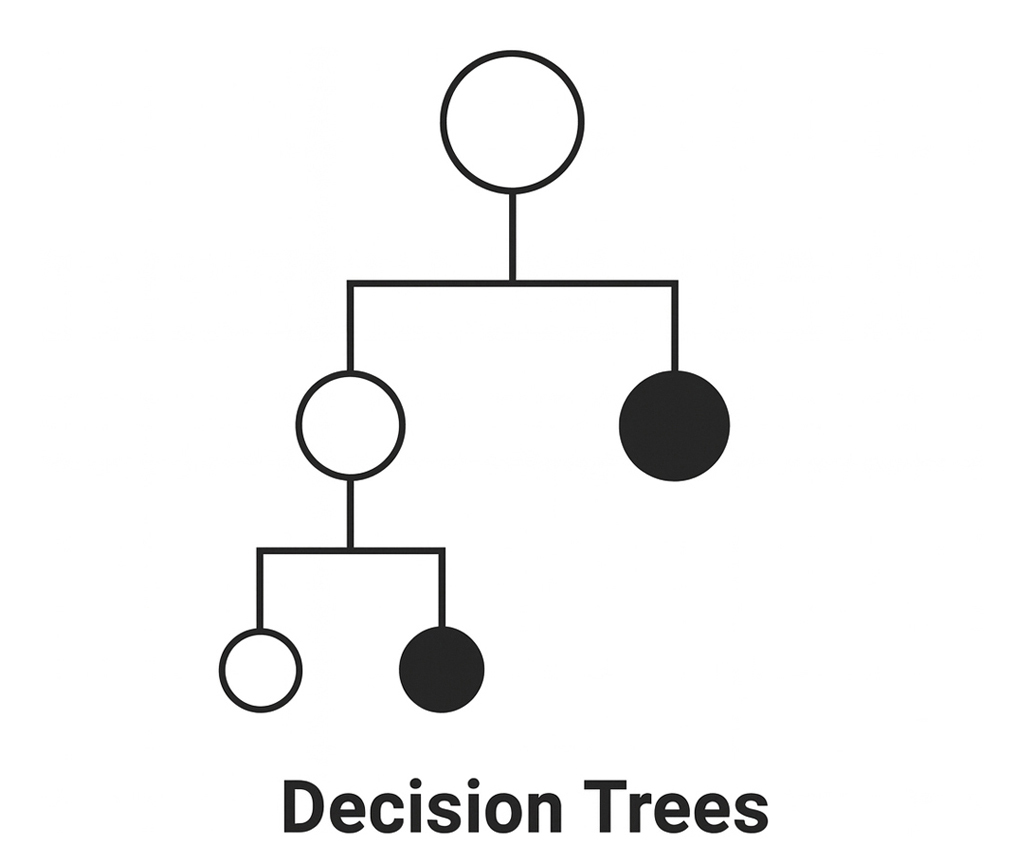

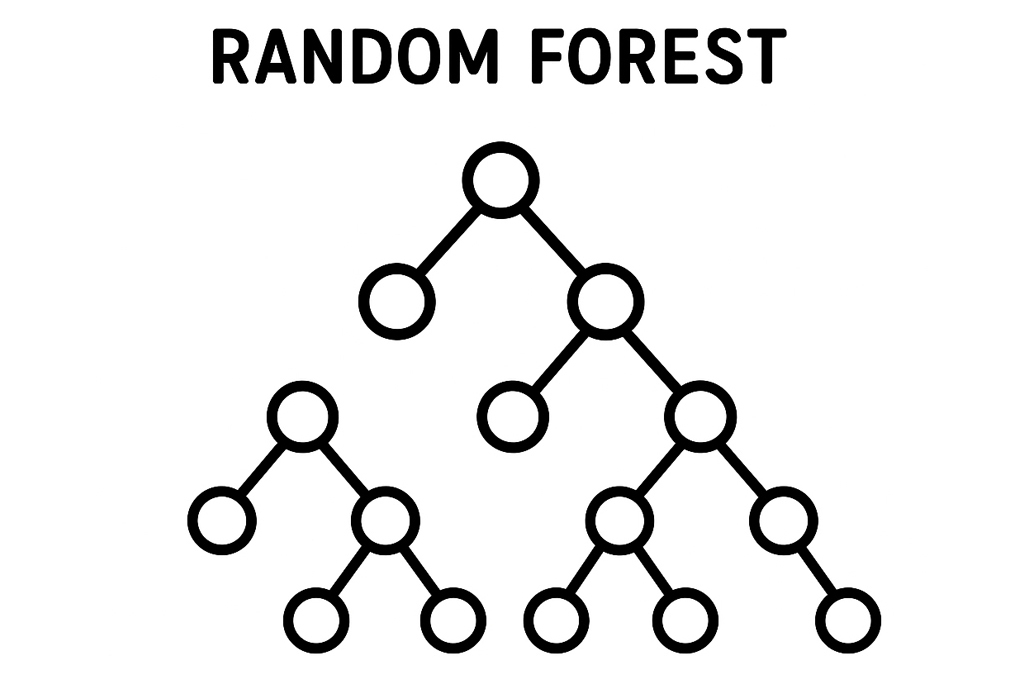

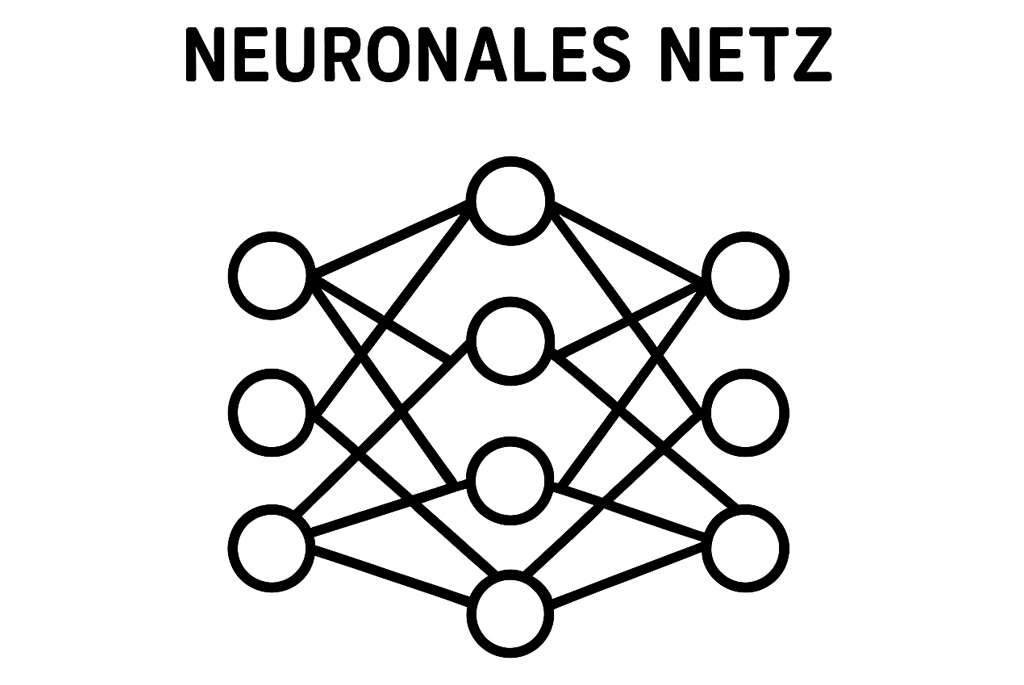

Klassifikationsmodelle

Dieser Modelltyp wird am häufigsten verwendet und zählt zu den überwachten maschinellen Lernmethoden. Kern ist die Sortierung historischer Daten in verschiedene Gruppen und die Beschreibung der Beziehungen dieser Gruppen untereinander. Zu den Klassifikationsmodellen zählen unter anderem

- das Random Forest Modell (kombiniert 500-1000 Entscheidungsbäume),

- neuronale Netze (dem menschlichen Gehirn nachempfundenen Modelle, die auf Milliarden von Knoten und deren Beziehungen zueinander aufbauen) und

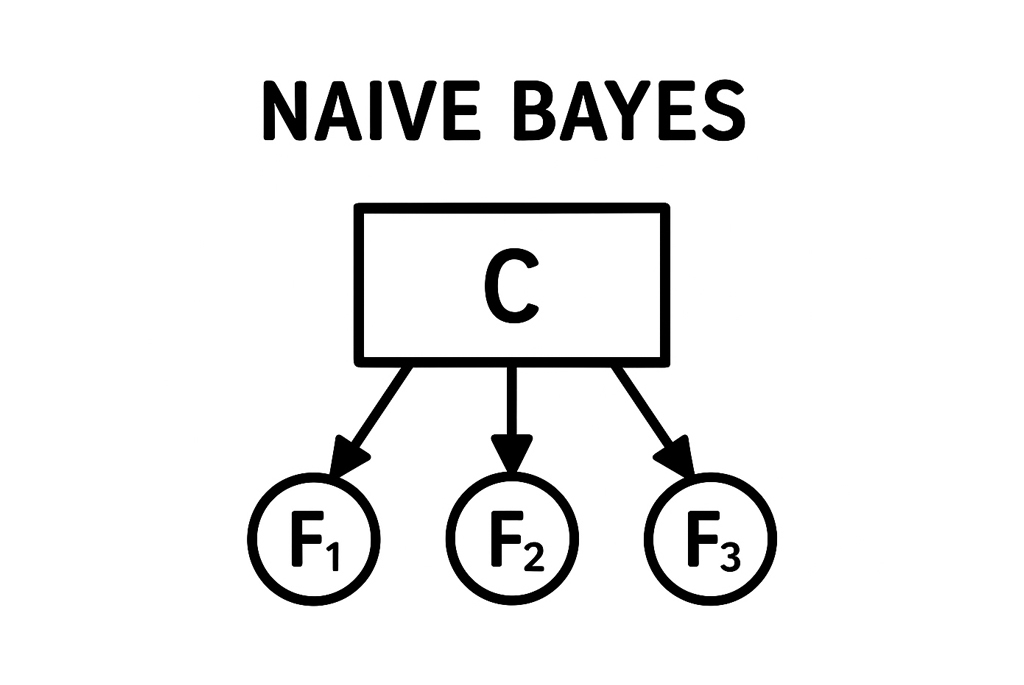

- Naive Bayes (nutzt Wahrscheinlichkeit, um die Beziehungen zwischen Ereignissen zu beschreiben).

Klassifikationsmodelle finden Anwendung im Versicherungswesen (Schadenwahrscheinlichkeit), im Gesundheitsbereich (Prognose von Risikopatienten) oder im Marketing (Kundensegmentierung).

Nutzen Sie schon Ihr volles Potenzial?

Clustering-Modelle

Clustering-Modelle gehören zu den unüberwachten Lernmodellen und sortiert Daten anhand ähnlicher Attribute. So können Unternehmen beispielsweise Kunden anhand ihres Geschlechts, Alters, Familienstands, Vermögens etc. in bestimmte Zielgruppen sortieren lassen, um diese dann gezielter ansprechen zu können. Zu den verwendeten Clustering-Modellen zählen

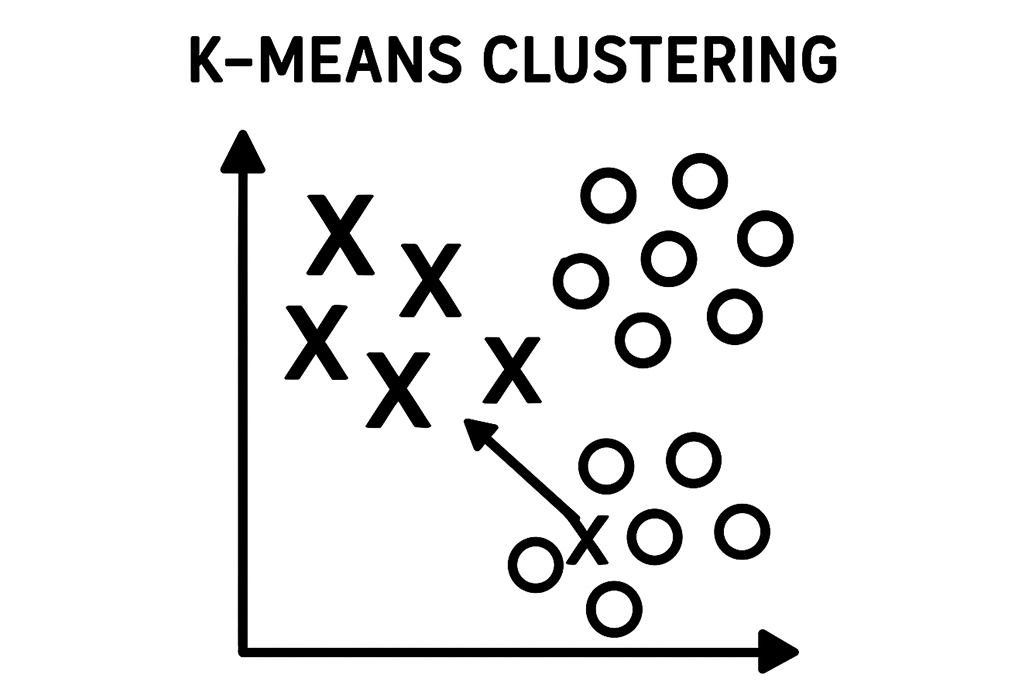

- k-means-Clustering (teilt Datenpunkte in eine vorab festgelegte Anzahl von Gruppen),

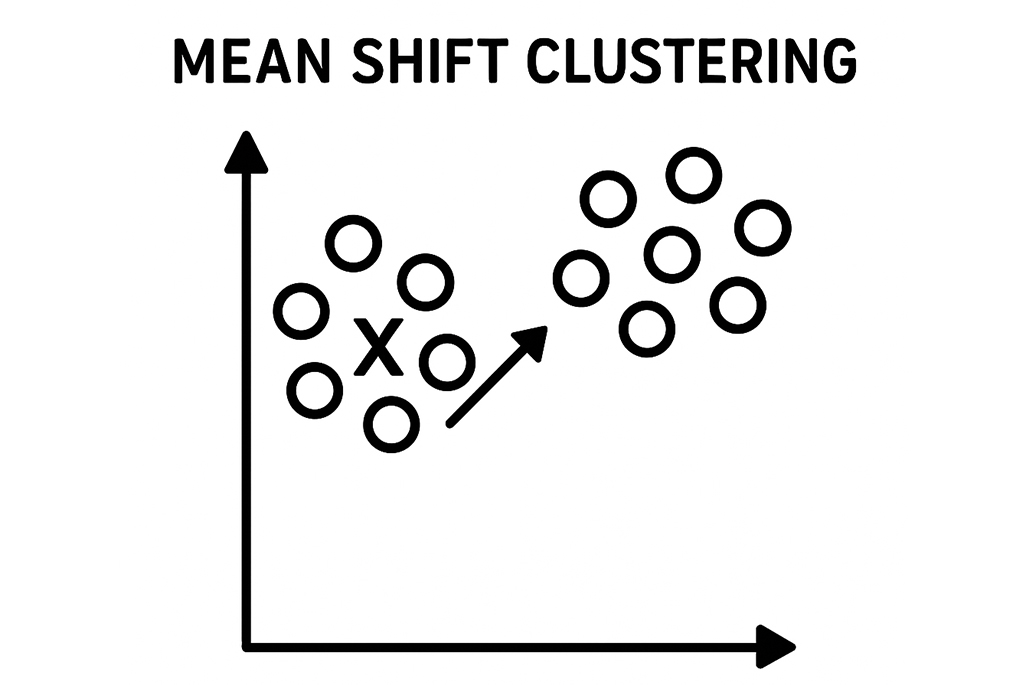

- Mean-Shift-Clustering (bündelt Datenpunkte zu Clustern und verschiebt dann umliegende Punkte, um größere Cluster zu erstellen),

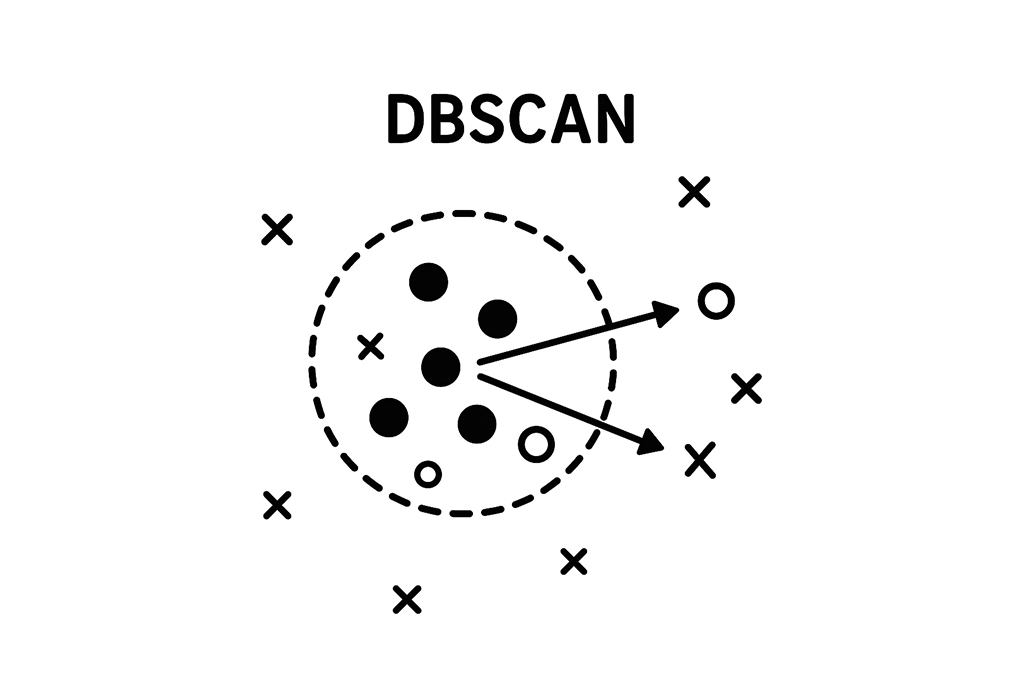

- dichtebasiertes räumliches Clustering von Anwendungen mit Rauschen (DBSCAN) (stellt nahe beieinander liegende Datenpunkte zu Clustern zusammen und ignoriert Ausreißer als Rauschen),

- Clustering zur Erwartungsmaximierung (EM) unter Verwendung von Gaußschen Mischmodellen (GMM) (Datenpunkte können gleichzeitig zu mehr als einem Cluster gehören) und

- hierarchisches Clustering (Baumstruktur, bei der Datenpunkte schrittweise in größere Gruppen zusammengefasst werden).

Clustering-Modelle helfen etwa beim Erkennen von Betrugsmustern im Finanzsektor, bei der Zielgruppenansprache im E-Commerce oder bei der Früherkennung von Anomalien in Maschinendaten.

Zeitreihenmodelle

Wie der Name des Modelles bereits vermuten lässt, stehen hier Zeitangaben in Verbindung mit bestimmten Ereignissen im Fokus. So lassen sich beispielsweise die optimalen Startzeitpunkte für die Bewerbung saisonaler Trends ermitteln oder der Mitarbeitereinsatz in der Gastronomie im Tagesverlauf optimieren. Eingesetzt werden unter anderem

- das autoregressive Zeitreihenmodell (AR) (errechnet aktuellen Wert anhand vorrangegangener Werte),

- der gleitende Durchschnitt (MA) (entfernt Ausreißer, um einen sauberen Durchschnittswert abzubilden)

- sowie ARMA- und ARIMA-Modelle (Kombination des autoregressiven Zeitreihenmodells mit dem gleitenden Durchschnitt).

Zeitreihenmodelle sind unerlässlich in der Produktion (Bedarfsplanung), Energieversorgung (Vorhersage des Verbrauchs) sowie für Wetter- und Verkehrsprognosen.

Welches der Modelle das sinnvollste ist, hängt von Einsatzzweck und Erkenntnisinteresse ab. Auch die Kombination von mehreren Modellen zu einem komplexen System, um zu neuen Erkenntnissen zu gelangen, ist ein denkbarer Weg zu spannenden Lösungsansätzen.

Herausforderungen und Grenzen

Die Effizienz der Predictive Analytics steht und fällt mit der Qualität und der Menge der zugrundeliegenden Daten. Je mehr vorhanden sind und je präzisier diese sind, desto besser sind die verschiedenen Systeme darin, Vorhersagen zu treffen.

Ebenfalls ratsam ist es, die Fragestellung, die an ein entsprechendes System herangetragen wird, möglichst eindeutig zu halten. Desto mehr Interpretationsspielraum vorhanden ist, desto unpräziser wird das Ergebnis ausfallen. Schlussendlich kommt an dieser Stelle auch noch der Faktor Mensch hinzu, der das Ergebnis auswerten, in einen Bezug setzen und aus den Erkenntnissen schlussendlich konkrete Handlungen ableiten muss. Das ist bei einfachen ja/nein-Modellen relativ simpel, bei mehrschichtigen Baumstrukturen mit multiplen Lösungsvarianten eine weit komplexere Aufgabe, die Erfahrung und Fachkenntnis voraussetzt.

Zuletzt setzt uns natürlich auch das Budget Grenzen. Auch wenn wir dank Cloudsystemen, starken Rechnern und Glasfaser zügig auf riesige Datenmenge zugreifen können, ist all dies mit Kosten verbunden. Hier sollten Unternehmen genau kalkulieren, wie viel ihnen der mögliche Wissensvorsprung wert ist. Zudem ist zu prüfen, ob das Ergebnis schlussendlich auch an die zuvor gestellten Anforderungen heranreicht oder dahinter zurückbleibt.

Datenschutz und der Umgang mit sensiblen Daten

Ein zentrales Thema abseits der technischen Umsetzung ist der verantwortungsvolle Umgang mit sensiblen Daten: Datenschutzrichtlinien wie DSGVO legen fest, dass personenbezogene Informationen nur mit geeigneten Schutzmaßnahmen verarbeitet werden dürfen. Hinzu kommt, dass KI-Modelle durch fehlerhafte, unausgewogene oder historisch verzerrte Daten (Bias) zu diskriminierenden Ergebnissen kommen können. Unternehmen sollten daher Transparenz schaffen, algorithmische Entscheidungen regelmäßig prüfen und Mechanismen zur Vermeidung von Diskriminierung entwickeln, damit Predictive Analytics vertrauenswürdig und fair bleibt.

Anwendungsbeispiele: Wer profitiert von Predictive Analytics?

Für viele Branchen ist die Predictive Analytics trotz der oben genannten Einschränkungen äußerst attraktiv, versetzt sie Entscheidungsträger schließlich in die Lage, Gelder effizienter zu investieren, Maßnahmen erfolgreicher zu steuern und Mitarbeiter besser einzusetzen. Die folgende Liste stellt mögliche Einsatzszenarien in verschiedenen Branchen vor. Sie ist sicher nicht vollständig und soll nur als Denkanstoß sowie zur Veranschaulichung des Potenzials dienen, das in dieser Technologie steckt:

- Marketing & E-Commerce: Vorhersage von Kundenverhalten, Personalisierung von Werbekampagnen und Produktempfehlungen, Erkennung abwanderungsgefährdeter Kunden.

- Finanzen & Versicherungen: Kreditrisikobewertung, Betrugserkennung, Prognose von Zahlungsausfällen.

- Gesundheitswesen: Prognose von Krankheitsverläufen, Ressourcenplanung im Krankenhaus, Identifikation von Risikopatienten.

- Produktion & Industrie: Vorhersage von Maschinenausfällen (Predictive Maintenance), Optimierung von Produktionsabläufen und Materialbedarf.

- Logistik & Supply Chain: Nachfrageprognosen, Optimierung von Lagerbeständen und Lieferketten, Transportplanung.

- Personalwesen (HR): Vorhersage von Mitarbeiterfluktuation, Talentmanagement und frühzeitige Erkennung von Personalengpässen.

- Immobilien: Bewertung von Immobilienpreisen, Marktanalyse und Investitionsentscheidungen.

- Betrugserkennung & Cybersecurity: Erkennung von verdächtigen Mustern und Prävention von Finanz- und IT-Betrug.

- Wettervorhersage & Wahlprognosen: Prognose von Wetterereignissen und Wahlausgängen auf Basis historischer Daten.

Bereit, die Zukunft Ihres Unternehmens mit KI zu gestalten?

Mathematik ist keine Magie

Predictive Analytics ist keine Zauberei, sondern rational fundierte Wahrscheinlichkeitsrechnung mit ungeahnt großem Potenzial. Unternehmen, die klug und verantwortungsvoll in ihre Daten- und Analysekompetenzen investieren, verschaffen sich entscheidende Vorteile – vorausgesetzt, sie berücksichtigen dabei auch die Herausforderungen von Datenschutz, Ethik und Modelltransparenz. Der Wandel zu mehr Präzision und Effizienz in Entscheidungsprozessen ist damit längst eingeläutet – und wird durch technologische Fortschritte weiter beschleunigt.